学术界和工业界对知识管理理论进行了深入而广泛的研究,然而迄今为止对知识管理涉及的具体内容及一般过程尚未形成统一认识。这里重点介绍图书情报领域专家的相关表述。其管理过程大致包括知识生产、组织、构建、检索、发现、分享、应用和创新等阶段。在知识经济的背景下,知识的发现、利用和创新是贯穿于高校图书馆各项业务工作的主线,知识管理理论也成为大数据时代图书馆大数据应用和服务的主要支撑理论。......

2023-07-24

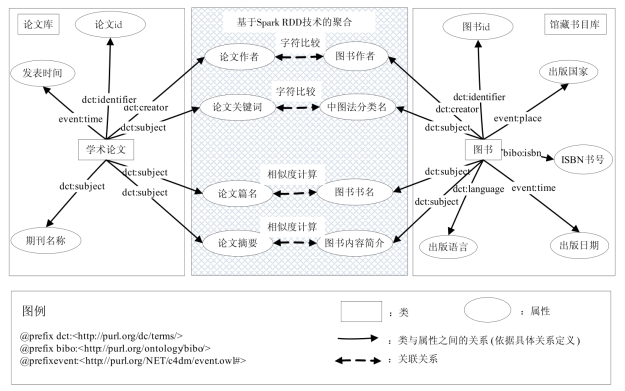

以学术论文数据库和馆藏书目数据库为基础数据库,采用关联数据技术实现两者聚合,为文献大数据的分析和应用提供“高相关度”的关联知识库。聚合过程如图4.3所示,主要包括本体模型构建和元数据关联两部分。

(1)本体模型构建。一般由“学术论文”和“图书”两个类(Class)构成,各类的属性及关联关系如图4.3所示,属性对应的数据值来自于领域本体数据库。经过调研,选择W3C组织推荐的知名本体库(图例部分)确定关联关系和属性类别。

图4.3 论文数据库和图书数据库本体模型和聚合

(2)元数据关联。为了实现论文库和馆藏书目库的“高相关度”文献的关联,首先分析文献之间的相关度。这里采取“字符比较”和“相似度计算”两种关联方式,前者适用于有较短字符串的元数据,后者适用于有较长文本的元数据。

①“字符比较”关联。选取学术论文库中元数据“论文作者”“论文关键词”,对应馆藏书目库中“图书作者”“中图法分类名”。共同特点是字符串简短,可通过字符比较的方式实现关联:如果两者字符相同,就将两条记录的id号关联起来,并定义权重,权重值的大小反映该类型关联的重要程度。

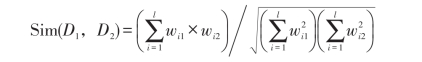

②“相似度计算”关联。选取学术论文库中元数据“论文篇名”和“论文摘要”,对应图书库中的“图书书名”和“图书内容简介”。其共同特点是文档较长,可通过计算文档相似度的方法实现关联:首先应用软件NLPIR[21],将文档拆成一个个分词,应用Spark相关函数统计分词的词频作为分词权重,构建分词向量空间模型,然后应用公式计算文档相似度Sim(D1,D2)并归一化,将其结果作为该类型关联的权重WSim。

公式中l为上述向量空间模型的分词列表长度,wi1、wi2分别为文档D1、D2对应分词的权重。

以下举例说明相似度计算技术。

设有两篇论文的题名分别为:

论文A:大数据时代数字图书馆面临的机遇和挑战(D1)

论文B:大数据时代下图书馆的挑战及其应对策略(D2)

按以下步骤计算它们的相似程度。

第一步:分词

句子A:大数据/时代/数字/图书馆/面临/的/机遇/和/挑战

句子B:大数据/时代/下/图书馆/的/挑战/及其/应对/策略

去掉停用词:“的,下,和,及其”

第二步:列出所有的词

大数据,时代,数字,图书馆,面临,机遇,挑战,应对,策略

第三步:计算词频

句子A:大数据1,时代1,数字1,图书馆1,面临1,机遇1,挑战1,应对0,策略0

句子B:大数据1,时代1,数字0,图书馆1,面临0,机遇0,挑战1,应对1,策略1

第四步:写出词频向量

句子A:(1,1,1,1,1,1,1,0,0)

句子B:(1,1,0,1,0,0,1,1,1)

第五步:计算文档相似度

使用公式(1),

计算过程如下:

至此,得出两篇论文题名的相似度为0.6172。

③构建Spark RDD三元组。三元组格式为(id1,id2,W),其中id1和id2是文献的id号,W等于两类关联权重Wchar与WSim之和。在代码实现过程中,引入Spark的RDD函数包(import org.apache.spark.rdd.RDD),调用Map函数的filter和flatmap等方法实施元数据与RDD的映射和交互操作,调用Join、Reducebykey和Groupby等函数实现文献id之间的关联。

2.文献排名

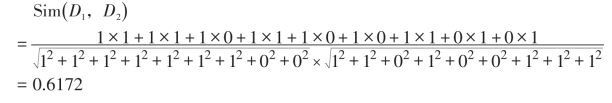

在上一步骤中,系统产生海量的文献关联记录,由于用户难以判断各文献的价值,需要对其排名:将与用户当前浏览的记录(用户感兴趣的文献)内容高度相关的文献排在TOP N位置。Spark GraphX图分析工具包可以用于海量文献的快速排名。作为分布式共享内存的图处理框架,Spark GraphX在主从式集群上实现了图的内存计算,在图的加载、节点和边处理以及相邻节点计算等方面更加优化,因而性能有较大提升。应用GraphX技术的排名包含以下四个过程,如图4.4所示。

图4.4 文献排名流程

(1)创建Graph(vertices,edges)并初始化为空图;

(2)将文献聚合产生的RDD转换为节点和边:从图书RDD和论文RDD文件分离出“图书id”或“论文id”,作为节点vertices(文献id,节点权重)中的文献id,其节点权重的初始值暂时设置为0;将RDD中格式为(id1,id2,W)的每一条记录对应转换为边edges(文献id1,文献id2,边权重),边权重初始值为RDD记录中的W值;

(3)对图中Graph(vertices,edges)所有节点,计算其所连接边的总权重,并将总权重设置为节点vertices的权重值;

(4)按照节点的总权重值从大到小排序。在检索界面的列表中按权重值大小显示检索结果。

代码实现过程中,引入Spark GraphX包(import org.apache.spark.graphx.{Edge,Graph,VertexId,VertexRDD}),调用其中的Graph(vertices,edges)方法构建图,aggregateMessages函数计算总权重,调用Ordering函数对节点总权重排序。

有关高校图书馆大数据应用模式与实证研究的文章

学术界和工业界对知识管理理论进行了深入而广泛的研究,然而迄今为止对知识管理涉及的具体内容及一般过程尚未形成统一认识。这里重点介绍图书情报领域专家的相关表述。其管理过程大致包括知识生产、组织、构建、检索、发现、分享、应用和创新等阶段。在知识经济的背景下,知识的发现、利用和创新是贯穿于高校图书馆各项业务工作的主线,知识管理理论也成为大数据时代图书馆大数据应用和服务的主要支撑理论。......

2023-07-24

图4.3论文数据库和图书数据库本体模型和聚合元数据关联。设有两篇论文的题名分别为:论文A:大数据时代数字图书馆面临的机遇和挑战论文B:大数据时代下图书馆的挑战及其应对策略按以下步骤计算它们的相似程度。......

2023-07-24

图书馆大数据应用必须密切结合图书馆大数据服务的需求,针对性地提出应用模式和解决方案,以促进图书馆大数据服务的真正落地。本书利用语义网这一工具和技术,融合语义网最新研究成果,提出一种基于语义网的学科知识服务模式。因此本书提出面向科研的高校图书馆电子资源使用统计模式。......

2023-07-24

大数据环境下个性化服务的研究引起学界重视。大数据技术的迅速发展以及图书馆个性化服务要求的不断提高,催生了大数据环境下个性化服务的研究,尤其是在关联数据技术与个性化服务结合方面取得了积极进展。以下结合大数据环境下个性化服务特征,讨论用户行为模型的构建策略。......

2023-07-24

本方案是基于内容的文献推荐方法,当用户浏览图书馆信息系统,点击感兴趣的文献链接时,系统查找与用户当前所点击的文献特征高相似度的文献,经过排名后实施推荐。本方案中用户兴趣建模和文献数据建模均采用“混合关联”方案,如图10.13所示。抽取图书数据库中的“书名”和“内容简介”,与论文数据库中的“篇名”和“中文摘要”等元数据实现关联。Spark库中有专用函数支持“相似性度量”关联的实现。......

2023-07-24

特别是随着阅读终端的多样化和社交媒体的广泛使用,形成了全方位、立体化的图书馆大数据。图书馆可用于满足智慧服务核心需求的重要大数据资源见表7.1。大数据挖掘作为知识发现、信息行为分析的重要研究方法,是图书馆数据展现数据智慧的关键技术之一。本节提出如图7.1所示的基于大数据挖掘的图书馆智慧服务模型,将大数据挖掘作为沟通图书馆智慧服务需求和大数据应用的桥梁。......

2023-07-24

为验证本方案的可行性和推荐性能,实现推荐系统并开展实证研究。按此规则共收集到1万多组数据。针对不同的调和参数α的准确率和多样率的统计结果如图10.15所示。......

2023-07-24

图书馆大数据具体应用模式的比较和分析。一方面,由于图书馆大数据应用服务的对象不同,导致服务的目的、要求、数据来源、数据特点有很大差异,所提出的高校图书馆大数据各种应用模式也有重大区别;另一方面,各种模式也存在诸多共同点,因此需要对其进行比较和分析。......

2023-07-24

相关推荐